Открытые модели искусственного интеллекта, находящиеся на подъеме, сотрясают рынок ИИ, разрушая удушающий контроль проприетарных моделей, работающих на проприетарном оборудовании, отмечают опрошенные порталом The New Stack эксперты.

В

Рынок ИИ движется по тому же пути, но окружающая обстановка отличается. Открытые модели ИИ, находящиеся на подъеме, сотрясают рынок ИИ, разрушая удушающие объятия проприетарных моделей, работающих на проприетарном оборудовании.

Облачные провайдеры, включая Google и Amazon, спешат развернуть открытые модели на своих проприетарных чипах. Это связано с тем, что потребители моделей ИИ хотят получить более низкую стоимость и повышенную гибкость, связанные с открытыми большими языковыми моделями (LLM). Эта тенденция совпадает с тем, как развивался Linux, на котором сейчас работает бóльшая часть Интернета.

«Если вы хотите идти быстро, идите в одиночку. Если хотите идти далеко, идите вместе», — говорит Фабрицио Дель Маффео, генеральный директор компании Axelera, производящей аппаратное обеспечение для ИИ.

Как мы к этому пришли?

Эра ИИ начиналась так же, как и эра ПК начиналась с проприетарного ПО Windows, работающего исключительно на аппаратном обеспечении x86.

Развитие Linux было связано с x86, и «именно Linux плюс x86 стали веб-стеком/LAMP-стеком», — отмечает Дэвид Кантер, основатель организации MLCommons, занимающейся бенчмаркингом ИИ.

По его словам, реальность такова, что «Linux действительно поглотил проприетарные Unix. Solaris больше нет, HP-UX больше нет, Tru64 определенно больше нет, лишь AIX все еще существует».

Открытые модели, такие как Llama и Gemma, также нарушают господство проприетарных моделей корпоративного ИИ, таких как Gemini и GPT-4.

Ранее на тензорных ИИ-чипах Google выполнялась только ее собственная LLM Gemini, но в начале этого года компания начала запускать на этих TPU свою открытую модель Gemma.

Amazon недавно сделала доступной на своем чипе Trainium2 модель Llama 3.1 с 405 млрд. параметров. «Trainium2 стоит дешевле, чем аналогичные экземпляры Nvidia, поэтому взять Llama2 405B и обучить ее на основе собственных данных клиента, чтобы создать пользовательскую модель, — вполне бюджетный подход», — говорит Джеймс Сандерс, аналитик TechInsights.

Что такое открытые модели?

Конечно, открытые модели и модели ИИ с открытым исходным кодом — это не одно и то же. В мире ПО вы можете изменять открытый код так, как считаете нужным. В то же время существует несколько определений того, что значит быть открытым в ИИ.

Организация Open Source Initiative (OSI) два месяца назад определила термин «Open Source AI» как «применяемый к системе, модели, весам и параметрам или другим структурным элементам». Это включает все обучающие данные.

Llama не подходит под определение OSI, но она в основном открыта с некоторыми ограничениями. Пользователи могут использовать Llama как предварительно обученную модель и настраивать ее под конкретные нужды. Но пользователи не могут получить доступ к данным Llama или изменить их, так как Meta (компания признана экстремистской и запрещена в РФ) не хочет раскрывать источники данных, которые она использовала для предварительного обучения модели.

Проприетарные модели, такие как Gemini, Claude и GPT-4, полностью закрыты.

Как Linux, привязать к себе клиентов

Облачные провайдеры идут по стопам поставщиков ОС Linux, таких как Red Hat, — «оборачивая» открытую ОС в проприетарную технологию и привязывая клиентов к программному стеку.

Открытые модели ИИ — это недорогой способ заманить клиентов в облачные сервисы. Если клиент привязан к поставщику облачных услуг, ему трудно его покинуть.

«Мотив заключается в том, чтобы привлечь больше клиентов к своим услугам, связанным с ИИ, таким как вычисления, управление данными, безопасность и хранение», — говорит Патрик Мурхед, главный аналитик Moor Insights and Strategy.

Trainium2 еще не перевернул мир, поэтому портирование Llama на Trainium2 повышает ценность чипов AWS. Компания также анонсировала свои собственные модели Nova, которые будут работать на Trainium. По словам Навина Рао, вице-президента Databricks по ИИ, AWS стремится к широкому охвату сценариев использования. «Поддержка большего количества моделей повышает актуальность аппаратного обеспечения, так что это, скорее всего, основная причина. Но это не даст очень большого эффекта для них», — говорит он.

Преимущества открытости

Открытый исходный код и открытые модели выгодны для облачных ускорителей ИИ. «Идеальное состояние — это предоставление знакомой среды с минимальным трением по низкой цене», — говорит Сандерс.

Открытые модели также позволяют создавать производные модели с открытым исходным кодом, более компактные и оптимизированные, которые могут лучше соответствовать требованиям конкретной отрасли.

«Добавление открытых моделей в каталог позволяет увеличить клиентскую базу и монетизировать услуги», — говорит Дель Маффео.

Groq, Sambanova, Cerebras и другие небольшие поставщики оборудования предоставляют открытые модели в качестве услуги по очень низкой стоимости токена.

Трудности развертывания открытых моделей ИИ

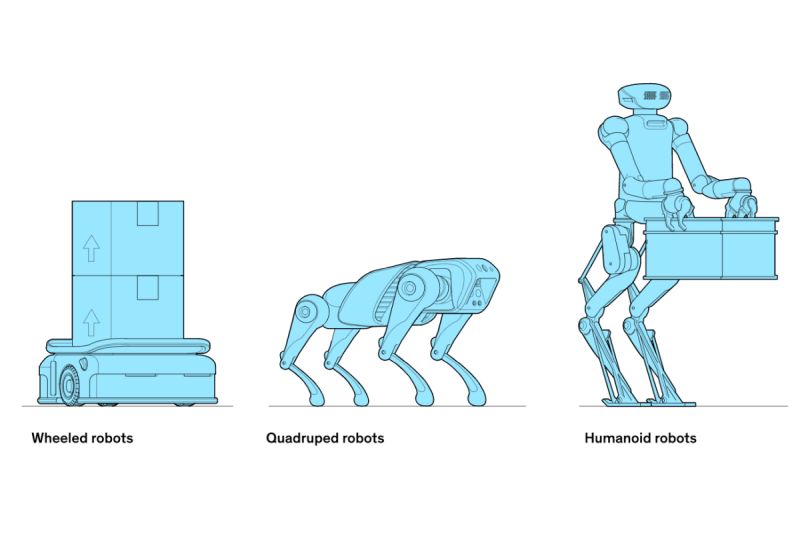

Развертывание открытых моделей ИИ на TPU от Google и Trainium от AWS может быть сопряжено с известными трудностями. Открытые модели нуждаются в специализированных форках для пользовательских чипов.

Открытые модели обычно строятся на фреймворках и цепочках инструментов, таких как PyTorch, JAX или TensorFlow. Разработчики используют встроенные в фреймворк инструменты и API для измерения производительности и достижения ее заданного уровня с помощью методов, включающих оптимизацию под архитектуру и чипы.

Для сравнения, графические процессоры Nvidia — это универсальные ИИ-ускорители, на которых могут работать любой ПК или ИИ-приложение.

HuggingFace способствует развитию ИИ с открытым исходным кодом на проприетарном оборудовании. Она предоставляет сотни открытых моделей, которые по точности и производительности не уступают более энергоемким моделям.

AWS сотрудничает с Hugging Face для обучения и развертывания моделей на Trainium.

«Теперь, когда рынок ускоряется, вполне естественно, что Amazon откроет доступ к своей инфраструктуре для любой другой модели с открытым исходным кодом», — считает Дель Маффео.

В июле HuggingFace объявила о том, что ее модели ИИ доступны для развертывания на TPU в Google Cloud.

«Учитывая растущую озабоченность по поводу увеличения энергопотребления, требований к охлаждению и стоимости обучения больших моделей, инновации сообщества, которые помогают облегчить эти проблемы, приветствуются», — отмечает Дель Маффео. Все больше разработчиков также приобретают опыт в разработке машинного обучения, и возможности сообщества могут покрыть потребности значительной части рынка ИИ.

Изменение определения

Предприятия уже используют смесь моделей с открытым и закрытым исходным кодом.

«На данный момент архитектура всех моделей в основном одинакова», — отмечает Рао. По его словам, с точки зрения аппаратного обеспечения разница между открытыми и закрытыми моделями гораздо больше зависит от данных и режима обучения, чем от архитектуры модели.

«Можно утверждать, что все модели, работающие на современном аппаратном обеспечении, имеют открытый исходный код или являются производными от Open Source-архитектур. Возможно, в будущем это изменится благодаря идее ускорения вывода (inference time-scaling), как в GPT-4o1», — говорит Рао.