Искусственный интеллект быстро развивается, оставляя организации открытыми для угроз. О том, почему нужно иметь возможность его отключить в случае необходимости, на портале Information Age рассказывает Дэвид Хиггинс, старший директор отдела полевых технологий компании CyberArk.

ИИ развивается с бешеной скоростью, и меры безопасности не успевают за ним. Недавняя кибератака на DeepSeek, новую Open Source-платформу ИИ, стала ярким напоминанием о том, что системы ИИ — особенно агентный ИИ — уязвимы перед теми же угрозами, которые нависли над всей цифровой экосистемой.

DeepSeek, которую часто называют «убийцей ChatGPT» за ее продвинутые языковые модели, ненадолго обогнала по популярности OpenAI с ее ChatGPT. Но так же быстро стала мишенью. Распределенная атака типа «отказ в обслуживании» (DDoS) заставила компанию прекратить регистрацию новых пользователей, пошатнув уверенность в надлежащей безопасности ее ИИ.

Это вовсе не единичный случай. Модели ИИ, как с открытым исходным кодом, так и проприетарные, все чаще подвергаются атакам, будь то враждебное машинное обучение, отравление данных или взлом API. По мере того как агенты ИИ будут выполнять все более важные бизнес-функции, эти риски будут только расти.

Чтобы решить эту проблему, индустрия ИИ должна пересмотреть свой подход к безопасности. Основополагающим элементом решения является «рубильник ИИ» — механизм, позволяющий остановить скомпрометированные системы ИИ до того, как они выйдут из-под контроля. И в основе этого «рубильника» лежит безопасность машинной идентификации.

Обоюдоострый меч ИИ

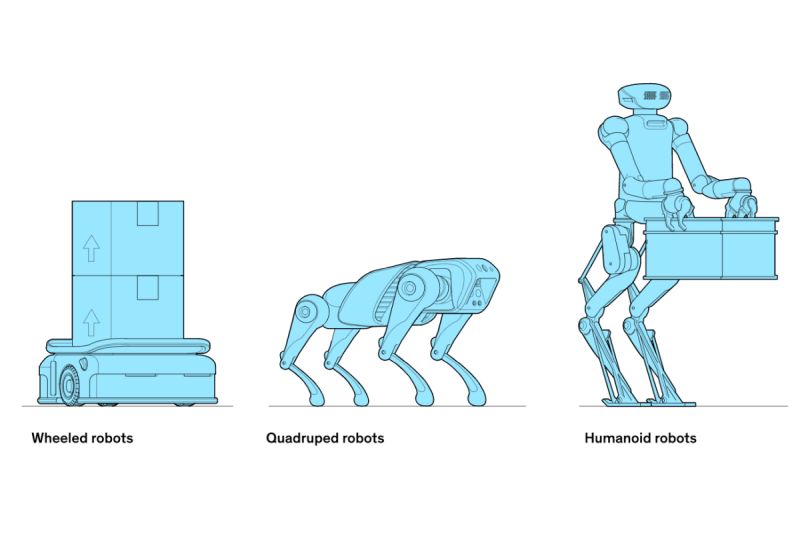

ИИ стал движущей силой цифровой трансформации, обеспечив прорыв в таких отраслях, как здравоохранение, финансы, логистика и маркетинг. Теперь, благодаря агентному ИИ, большие языковые модели (LLM) выходят за рамки генерации текста и переходят к автономным действиям. Однако столь значительный прогресс сопряжен со значительными рисками. Как ИИ ускоряет инновации, так он расширяет и возможности киберпреступников.

В случае с DeepSeek несколько исследователей обнаружили уязвимости в ее системах, в том числе джейлбрейк, который позволяет создавать вредоносные продукты, такие как программы-вымогатели и даже инструкции по разработке токсинов. Тем временем другая исследовательская группа недавно обнаружила открытую базу данных ClickHouse, через которую просачивались конфиденциальные данные, включая историю чатов пользователей, потоки журналов, секреты API и операционные детали. Они также обнаружили, что это позволяет получить полный контроль над базой данных, а также повысить привилегии — без аутентификации.

Это лишь несколько примеров того, что NIST относит к категории атак Adversarial Machine Learning (AML, вредоносное МО), которые используют слабые места в моделях ИИ на различных этапах их жизненного цикла — от разработки и тестирования до развертывания.

Проведенное в 2024 г. исследование CyberArk «Organizations Struggle to Secure AI-Generated and Open Source Code» выявило ряд опасений лидеров в области безопасности по поводу ИИ: 92% из них опасаются использования кода, созданного ИИ, 77% беспокоятся об отравлении данных, когда злоумышленники манипулируют обучающими данными, чтобы исказить результаты работы ИИ, и 75% серьезно обеспокоены кражей моделей ИИ.

Эти опасения по-прежнему сильны, учитывая тот поразительный уровень внимания, который получили атаки на DeepSeek. Ведь, как показал этот случай, эффективные атаки не просто нарушают работу. Они могут иметь глобальные последствия.

Что такое «рубильник ИИ» и зачем он нужен?

Будь то злоумышленник, испортивший или укравший модель, киберпреступник, выдающий себя за ИИ, чтобы получить несанкционированный доступ, или новая форма атаки, которую мы еще не видели, командам безопасности необходимо действовать на опережение. Именно поэтому «рубильник ИИ» имеет решающее значение. Он дает возможность организациям приостановить, сдержать или отключить скомпрометированные системы ИИ до того, как они нанесут серьезный ущерб.

Это не просто механизм отключения, а обеспечение контроля с помощью защиты идентификационных машинных данных. Проверяя и управляя уникальными идентификаторами моделей ИИ во время обучения, развертывания и эксплуатации, организации могут предотвратить несанкционированный доступ, отключить скомпрометированные системы и остановить распространение угроз по сети. Без этого системы ИИ останутся уязвимыми для масштабной эксплуатации.

Недостающий фрагмент головоломки: безопасность машинной идентификации

Как создать «рубильник ИИ»? Ответ кроется в защите всей экосистемы, ориентированной на машины, от которой зависит ИИ. Машинные идентификаторы, такие как цифровые сертификаты, токены доступа и ключи API, аутентифицируют и авторизуют функции ИИ и их возможности по взаимодействию с источниками данных и доступу к ним. Проще говоря, LLM и системы ИИ построены на коде, и, как любой код, они нуждаются в постоянной проверке для предотвращения несанкционированного доступа или несанкционированного поведения.

Если злоумышленники взломают эти идентификационные данные, системы ИИ могут стать инструментами, способными генерировать программы-вымогатели, проводить фишинговые кампании и сеять общий хаос. Защита машинных идентификаторов позволяет ИИ оставаться надежным, даже когда он расширяется и начинает взаимодействовать со сложными сетями и базами пользователей — задачи, которые могут и будут выполняться автономно с помощью агентов ИИ.

Без надежного управления и надзора компании рискуют потерять контроль над своими системами ИИ, что сделает их уязвимыми. Злоумышленники могут использовать слабые меры безопасности, применяя такие тактики, как отравление данных и проникновение через бэкдор — угрозы, которые развиваются быстрее, чем осознают многие организации.

Атака на DeepSeek — это тревожный сигнал для ИИ и кибербезопасности. Компании, правительства и исследователи должны выйти за рамки реактивного реагирования и разработать системы безопасности, которые будут развиваться так же быстро, как и угрозы, связанные с ИИ.

Безопасность машинной идентификации — важнейший первый шаг, обеспечивающий доверие и устойчивость в мире, управляемом ИИ. Эта задача становится еще более актуальной в условиях, когда агентный ИИ принимает на себя функции автономного принятия решений в различных отраслях.

Экономические, технологические риски и риски безопасности слишком велики, чтобы их игнорировать. Без правильных мер защиты, таких же сильных, как и сама технология, потенциал прогресса ИИ может легко превратиться в обузу.