Быстрое развитие информационных технологий на протяжении последних пятидесяти лет привело к захватывающим результатам. Представьте себе: сегодня мы в состоянии использовать мощные процессоры, огромную по объему оперативную память и высокопроизводительные сетевые интерфейсы в недорогих, но достаточно эффективных персональных электронных устройствах, обеспечивая эффективное взаимодействие для миллионов людей и устройств по всему миру.

Открывая огромные возможности, эта ситуация также создает некоторые трудности, поскольку вычисления в таких огромных масштабах генерируют данные со скоростью, превышающей возможности управления. Вот почему, несмотря на постоянное снижение удельной стоимости хранения данных, большинство крупных компаний отмечают непрерывный рост затрат на хранение информации. Например, одна из таких компаний, специализирующая на финансовом консалтинге, сообщила о росте объема хранимых данных с 4 до 40 Пб всего за два последних года.

Добро пожаловать в эру больших данных. Во многих смыслах, большие объемы данных — это новый рубеж, обозначающий переход к рынку постоянно взаимосвязанных покупателей и поставщиков, позволяющему налаживать коммуникации и предпринимать действия с целью предоставления персонализированных, релевантных предложений с потрясающей скоростью, автоматически и с помощью сложной логики. Возможности здесь просто огромны.

Опытные ИТ-директора видят эти возможности в контексте. Они знают, что использование больших объемов корпоративных данных для расчета актуальных деловых показателей будет требовать сфокусированной стратегии, использующей и защищающей существующие информационные массивы, развивающей новые возможности, тиражируемые и готовые к запуску в производство, а также способной управлять океаном новых данных, которые появятся в процессе этой работы.

Наше общение с ИТ-директорами компаний из списка Fortune 100 позволило сформулировать несколько ключевых направлений работы с возможностями и проблемами, создаваемыми применением больших данных.

Данные, информация или результаты анализа?

Для многих компаний происходящий сейчас взрывной рост объема данных не является результатом увеличения числа деловых операций или лучшего использования информации и аналитических исследований. Скорее, это результат неуправляемой репликации данных. По электронной почте широко рассылаются значительные по объему документы (презентации, PDF-файлы, видеозаписи и т. д.); сотни выборок из производственных информационных систем ежедневно копируются в базы данных департаментов и удаленных филиалов; недоработанные процессы архивирования и удаления информации влекут рост избыточных данных. Ценность работы с большими объемами состоит в возможности получения качественно новой информации в результате анализа данных, а не в копировании имеющейся информации. Для движения в правильном направлении есть три основных метода.

Сначала необходимо отделить сигнал от шума: начните снижать общий уровень информационного шума, ограничивая и упрощая инфраструктуру хранения данных с помощью ILM (information lifecycle management — управление жизненным циклом информации) и управления данными. Это не означает, что вы должны ждать перед тем, как начинать работу с большими объемами, просто следует планировать процесс так, чтобы вы могли удалять по два устаревших источника данных на каждый новый.

Затем необходимо определить (в широком смысле), какую новую информацию и аналитику можно получить, используя большие объемы данных и как это повлияет на бизнес. Мы выполнили несколько исследований, призванных проиллюстрировать этот тезис в действии. Вот некоторые из акций, которые можно предпринять.

Мнение покупателя. Ежедневно анализируйте обращения покупателей по телефону и электронной почте с помощью специальных инструментов анализа текста для понимания приоритетности проблем с продуктами и услугами, а также необходимых покупателям функций.

Ускорение процессов аналитики. Создайте мультитерабайтные готовые к анализу базы данных для поддержки основных аналитических задач, таких как сегментация покупателей по рынкам. Используя эту методику, одна компания смогла ускорить выход своих продуктов на рынок в 10 раз.

Определение бизнес-событий. Создайте каналы для выявления важных деловых событий во время работы с покупателями и автоматизируйте реакцию. В крупной страховой компании, например, своевременное, сфокусированное реагирование на поведение клиентов, основанное на подобной идентификации, повысило объем продаж на 20% и улучшило показатель удержания покупателей на 10%.

И наконец, определите минимально допустимый масштаб для успешного выполнения работы. Будьте строги при выборе необходимой информации и решите, являются ли большие массивы данных единственно возможным вариантом. Если да, оцените наименьший объем данных, необходимый для генерирования этой информации. Задайте вопросы — какие границы статистической выборки необходимы для качественного анализа тренда? Насколько гранулированными должны быть данные?

Для аналитических проектов грамотная выборка отдельных отрезков статистических данных может привести к тем же выводам, что обработка всего объема накопленной информации. Большинство крупных компаний стремятся понять примерные, постоянные закономерности в поведении покупателей и производительности продукции для соответствующей оптимизации собственных бизнес-процессов и выпускаемых товаров. Анализ действий 500 000 случайно выбранных покупателей автомобилей даст примерно те же результаты, что и анализ действий 50 млн. Пока ваш бизнес не может использовать преимущества микросегментации и пожинать плоды от продаж нишевых продуктов (товаров “длинного хвоста”), строгие правила отбора и анализа данных позволят получить качественные результаты, способные служить основой для дальнейших действий.

Используйте технологию работы с большими массивами

Динамические, сетевые бизнес-процессы, построенные с высокой степенью детализации, могут генерировать миллиарды и триллионы байтов информации каждый месяц. Учитывая это, следует понимать, что требования больших объемов данных традиционно опережали любые улучшения в цене/производительности технологий. К счастью, новые архитектуры и подходы, развиваемые в последнее десятилетие, смогли значительно упростить управление этими чудовищными массивами данных и были, в конце концов, интегрированы в корпоративную архитектуру многих крупных компаний.

Сюда относятся:

- программно-аппаратные комплексы и ускорители для баз данных. Значительные усовершенствования технологии реляционных баз данных на протяжении последнего десятилетия позволяют быстро и эффективно загружать и обрабатывать на одной платформе терабайты и даже петабайты данных. Специализированные устройства объединяют хранение, обработку, подключение и быстрое выполнение запросов на выделенной программно-аппаратной платформе, оптимизированной для работы и управления базой данных. Ускорители баз данных используют самые последние достижения в хранении данных и оптимизации запросов для снижения размеров базы данных и повышения скорости выполнения сложных запросов. Если просто обновление аппаратной платформы может повысить производительность традиционной реляционной базы данных в два раза, то применение специализированных устройств и ускорителей способно улучшить показатель “цена/производительность” почти в 100 раз. Наиболее важно, что эти технологии упрощают управление и администрирование, устраняя потребность в квалифицированной настройке и конфигурировании;

- NOSQL хранилища данных. Технология Not-Only-SQL, буквально рожденная в среде Интернета, с самого начала была спроектирована для управления огромными распределенными наборами данных, запрос к которым должен был выполняться за миллисекунды. Вместо нормализации данных по реляционным таблицам, которые затем должны объединяться для ответов на запросы, сверхбольшие массивы данных распределяются по сотням или тысячам процессоров, организованных так, чтобы связанные данные располагались рядом. Запросы выполняются параллельно на всех процессорах; каждый возвращает ответы, основываясь на своих локальных данных. Этот невероятно простой и масштабируемый подход оказался очень эффективным и гибким, позволяя совместно хранить данные самых разных типов, а также выполнять сложные запросы;

- автоматизированная аналитика. Чтобы получить преимущество от обработки сверхбольших массивов данных, требуется хорошая аналитика, и в большинстве компаний это удел небольшой группы высококвалифицированных специалистов. Выборка, очистка и обработка терабайтов данных часто представляют собой скорее искусство, чем науку, и большинство аналитиков скажет вам, что выполняемые ими ручные операции не могут быть автоматизированы. Однако прогресс, достигнутый в последнее десятилетие в самообучающихся алгоритмах, генетических алгоритмах и автоматизированном тестировании, привел к появлению программ, способных распознавать образцы, делать заключения и улучшаться с течением времени — другими словами, они самообучаются. Эти системы могут не всегда превосходить своих “коллег”-людей, но их автоматизированные процессы могут оказаться единственным способом масштабирования в соответствии с требованиями сверхбольших массивов.

Велико значение технологии обработки больших данных для снижения объемов и сложности хранимой информации. Например, большинство крупных компаний используют процессы управления важными для бизнеса событиями, такими, как реакция на потенциальную попытку мошенничества или на обращение за поддержкой. Технология работы с большими данными позволяет сканировать миллиарды транзакций для определения или предугадывания важных бизнес-событий; после чего — в качестве реакции — могут запускаться уже традиционные технологии и процессы. В этом качестве технология сверхбольших данных выступает как преобразователь, превращающий какофонию данных в полезную, управляемую информацию.

Данные — Оценка — Действия

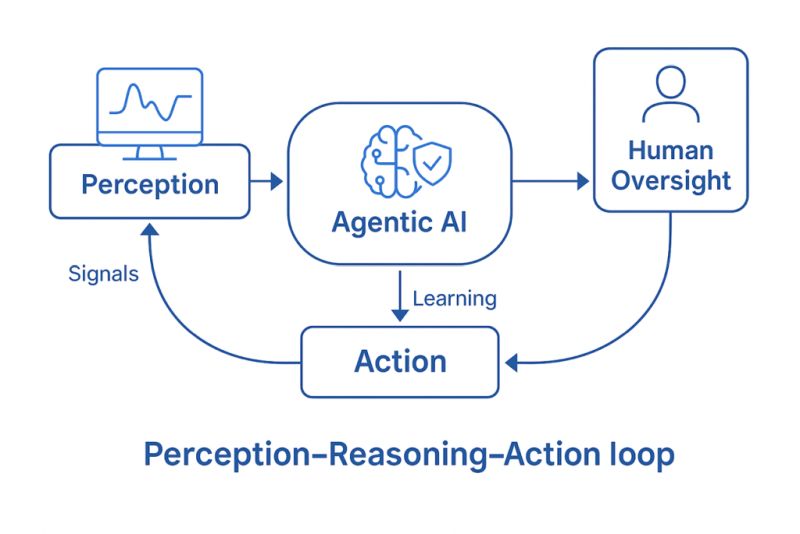

Большие массивы данных должны рассматриваться в контексте корпоративных данных и системы аналитики, которые мы воспринимаем как общую экосистему: получение и создание данных, их очистка и систематизация, анализ данных с точки зрения бизнеса и составление на основе его результатов плана бизнес-действий. Направление информации о результатах этих бизнес-действий назад в систему создает замкнутый цикл, позволяющий компаниям использовать свои данные для тестирования, изучения и улучшения бизнес-процессов. Таким образом, три основные области экосистемы больших данных: данные, анализ, действия.

Механизмы работы с данными отвечают за создание и управление готовыми к использованию, высококачественными информационными активами предприятия. Сюда относятся все стандартные средства управления данными, такие как работа с источниками данных и интеграция, управление метаданными и контроль качества, моделирование данных, руководство данными. Средства анализа включают инструменты, данные и процессы для управления отчетностью и глубокого анализа. Возможности действий обеспечивают доступность данных и бизнес-правил для приложений, бизнес-процессов и бизнес-партнеров и обмен данными при взаимодействии объектов.

Сверхбольшие объемы предоставляют возможности и вызовы в каждой из этих областей. Технологии больших данных используются для устранения избыточности и обеспечения масштабируемой инфраструктуры для управления глобальными информационными активами. Анализ выполняется с использованием программно-аппаратных комплексов и ускорителей, технологии NOSQL и автоматизированных аналитических инструментов для улавливания и формулирования закономерностей, скрытых в сверхбольших массивах. Бизнес применяет сделанные выводы с помощью интеллектуальных агентов, влияющих как на внутренние, так и на внешние коммуникации и взаимодействия.

Заключение

Большие данные представляют собой завораживающую возможность для анализа и инноваций, а также вызов в области выделения сигнала из шума. Все чаще компании перемежают их собственную, внутреннюю информацию с выводами, сделанными на основе внешних структурных и неструктурных данных для лучшего понимания своих клиентов, своей эффективности и места на рынке. Новые технологии делают большие данные полезными и управляемыми, однако тщательное планирование на основе требований бизнеса и управление остаются существенно важными для достижения успеха. Начав с формулирования четких бизнес-целей, компании постепенно учатся управлять драматическим ростом объемов информации, анализируют результаты и постоянно оптимизируют свою деятельность.

Автор статьи — управляющий партнер и основатель NewVantage Partners.