Три закона робототехники Айзека Азимова десятилетиями будоражили воображение и заложив основу для этичного искусственного интеллекта задолго до того, как он стал реальностью, пишет на портале Datanami Ариэль Кац, генеральный директор компании Sisense, поставщика аналитических решений.

Впервые эти законы были представлены в 1942 г. в рассказе «Беглец» из цикла «Я, робот»:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму законам.

Сейчас, когда мы стоим на пороге будущего, управляемого ИИ, видение Азимова актуально как никогда. Но достаточно ли этих законов, чтобы провести нас через этические сложности продвинутого ИИ?

Будучи подростком, я был очарован творчеством Азимова. Его рассказы рисовали яркую картину будущего, где люди и физические роботы, а также, хотя я тогда и не представлял их себе, программные роботы, гармонично сосуществуют в рамках этических принципов. Его «Три закона» были не просто научной фантастикой, а глубоким комментарием к отношениям между человечеством и его творениями.

Но я всегда чувствовал, что они не полны. Возьмем, к примеру, такой сценарий, как автономные автомобили. Эти автомобили, управляемые ИИ, должны постоянно принимать решения, которые балансируют безопасность их пассажиров и пешеходов. В случае потенциальной аварии, как ИИ автомобиля должен определить приоритеты, чью безопасность защищать, особенно если любое решение может нанести вред в той или иной форме?

В 1985 г. Азимов добавил Нулевой закон:

- Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечество пострадало.

Это всеобъемлющее правило должно было гарантировать, что коллективное благосостояние человечества превалирует над правилами для отдельных людей.

Однако даже с учетом этого дополнения практическое применение этих законов в сложных реальных сценариях остается трудной задачей. Например, как автономный автомобиль должен интерпретировать Нулевой закон (и три других) в ситуации, когда предотвращение вреда одному человеку может привести к большему вреду для всего человечества? Эта дилемма иллюстрируют сложную и часто противоречивую природу принятия этических решений в ИИ, подчеркивая необходимость постоянного совершенствования руководящих принципов.

Важно помнить, что законы Азимова — это вымысел, а не всеобъемлющая этическая система. Они были созданы в качестве сюжета для рассказов, а сам Азимов часто исследовал «крайние случаи», чтобы подчеркнуть ограничения и противоречия в ситуациях с неопределенностью, вероятностью и риском. Сегодня автономным автомобилям приходится принимать решения в неопределенной обстановке, где некоторый уровень риска неизбежен. Три (или четыре) закона не всегда могут справиться со сложными сценариями реального мира и более широкими общественными последствиями, выходящими за рамки индивидуальной безопасности человека, такими как равенство, счастье или справедливость. Это делает перевод абстрактных этических принципов в точные правила, которые можно запрограммировать в системе ИИ, чрезвычайно сложной и увлекательной задачей.

Проблемы, связанные с реализацией законов Азимова

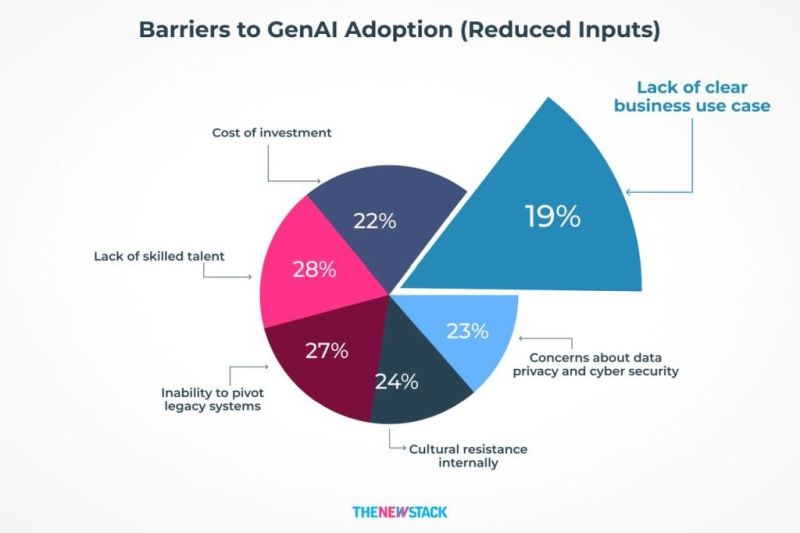

Перенесемся в настоящее, когда генеративный ИИ (GenAI) проникает во все, и обнаружим, что сталкиваемся с теми самыми проблемами, которые предвидел Азимов. Это подчеркивает важность развития законов Азимова до более глобальных и всеобъемлющих рамок. Как определить понятие «вред» в мире, где физическое, эмоциональное и психологическое благополучие взаимосвязаны? Можем ли мы доверить ИИ правильно интерпретировать эти нюансы? Сложно представить, как сам Азимов интерпретировал бы свои законы в этой GenAI-реальности, но было бы интересно узнать, какие изменения или дополнения он мог бы предложить, будь он жив сегодня.

Давайте рассмотрим еще несколько примеров из современного ИИ-ландшафта:

- ИИ в здравоохранении. Передовые системы ИИ могут помочь в диагностике и лечении пациентов, но при этом они должны учитывать вопросы конфиденциальности и согласия пациента. Если ИИ обнаружит угрожающее жизни состояние, которое пациент желает сохранить в тайне, должен ли он действовать для спасения жизни пациента против его воли, потенциально причиняя психологический вред?

- ИИ в правоохранительных органах. Алгоритмы предиктивной работы полиции могут помочь предотвратить преступления, анализируя данные для прогнозирования вероятности их совершения. Однако эти системы могут непреднамеренно усилить существующие предубеждения, что приведет к дискриминационным практикам, наносящим ущерб определенным сообществам как в эмоциональном, так и в социальном плане.

- ИИ на транспорте. Возможно, вы знакомы с «Проблемой троллейбуса» — этическим мысленным экспериментом, в котором ставится вопрос о том, допустимо ли с моральной точки зрения направить несущийся троллейбус так, чтобы убить одного человека, а не пятерых. Представьте, что эти решения затрагивают тысячи или миллионы людей, и вы увидите потенциальные последствия.

Более того, потенциал для конфликта между законами Азимова становится все более очевидным. Например, ИИ, созданный для защиты человеческой жизни, может получить приказ, подвергающий опасности одного человека ради спасения многих других. Программирование ИИ будет поставлено перед необходимостью подчиниться приказу и предотвратить вред, демонстрируя сложность этических рамок Азимова в современном мире.

Четвертый закон: необходимая эволюция?

Что же еще мог бы предложить Азимов сегодня, чтобы решить некоторые из этих дилемм при применении его «Трех законов» в реальном мире в масштабе? Моя точка зрения такова: возможно, необходимо сосредоточиться на прозрачности и подотчетности:

- Робот должен быть прозрачным в своих действиях и решениях и нести за них ответственность, обеспечивая человеческий надзор и вмешательство в случае необходимости.

Этот закон учитывал бы современные проблемы, связанные с принятием решений ИИ, подчеркивая важность человеческого надзора и необходимость того, чтобы системы ИИ отслеживали, объясняли и при необходимости спрашивали разрешения на свои действия прозрачно. Это поможет предотвратить неправильное использование ИИ и обеспечить контроль со стороны человека, преодолевая разрыв между этической теорией и практическим применением. Мы не всегда можем знать, почему ИИ принимает то или иное решение в данный момент, но мы должны иметь возможность проработать проблему в обратном порядке, чтобы улучшить решения в будущем.

В здравоохранении прозрачность и подотчетность решений, принимаемых ИИ, обеспечит принятие мер с информированного согласия, поддерживая доверие к системам ИИ. В правоохранительных органах прозрачность потребует от систем ИИ объяснять свои решения и добиваться контроля со стороны человека, что поможет смягчить предвзятость и обеспечить более справедливые результаты. В автомобильной промышленности нам необходимо знать, как ИИ интерпретирует потенциальный вред для пешехода, переходящего дорогу, по сравнению с риском столкновения с автомобилем, движущимся на скорости в противоположном направлении.

В ситуациях, когда ИИ сталкивается с противоречиями между законами, прозрачность процесса принятия решений позволит вмешаться человеку, чтобы разрешить этические дилеммы и обеспечить соответствие действий ИИ общественным ценностям и этическим нормам.

Этические соображения на будущее

Развитие ИИ заставляет нас столкнуться с глубокими этическими вопросами. По мере того как роботы становятся все более автономными, мы должны задуматься о природе сознания и интеллекта. Если системы ИИ обретут сознание, как нам следует к ним относиться? Заслуживают ли они прав? Отчасти на создание «Трех законов» автора вдохновил страх, что роботы (или ИИ) могут поставить свои собственные «потребности» выше человеческих.

Наши отношения с ИИ также поднимают вопросы о зависимости и контроле. Можем ли мы гарантировать, что эти системы всегда будут действовать в интересах человечества? И как нам управлять рисками, связанными с развитым ИИ, — от замещения рабочих мест до проблем с конфиденциальностью?

Три закона робототехники Азимова вдохновляли целые поколения мыслителей и новаторов, но это только начало. По мере того как мы вступаем в эпоху, когда ИИ станет неотъемлемой частью нашей жизни, мы должны продолжать совершенствовать наши этические рамки. Предлагаемый Четвертый закон, подчеркивающий прозрачность и подотчетность, а также Нулевой закон, обеспечивающий благосостояние всего человечества, могут стать важнейшими дополнениями к тому, чтобы ИИ оставался инструментом на благо человека, а не потенциальной угрозой.

Будущее ИИ — это не просто технологический вызов, это глубокий этический путь. Наследие Азимова напоминает нам о важности предвидения, воображения и неуклонной приверженности этическим принципам. Путешествие только начинается, и вопросы, которые мы задаем сегодня, будут определять ландшафт ИИ для последующих поколений.

Давайте не просто унаследуем видение Азимова — давайте срочно развивать его, ведь когда речь идет об автономных роботах и ИИ, то, что было научной фантастикой, становится реальностью сегодняшнего дня.