Портал The New Stack представляет пять ведущих вариантов мультимодальных систем искусственного интеллекта с открытым исходным кодом, указывая на их особенности и сферы применения.

Мультимодальный ИИ привлекает большое внимание благодаря манящему обещанию универсальности — способности обрабатывать комбинации текста, изображений, аудио и видео.

И хотя на рынке уже существует целое созвездие мощных проприетарных мультимодальных систем ИИ, небольшие мультимодальные модели и Open Source-альтернативы также быстро завоевывают позиции, поскольку пользователи продолжают искать более доступные и адаптируемые варианты, а также отдают приоритет прозрачности и сотрудничеству. Ниже представлены некоторых из наиболее популярных Open Source-вариантов.

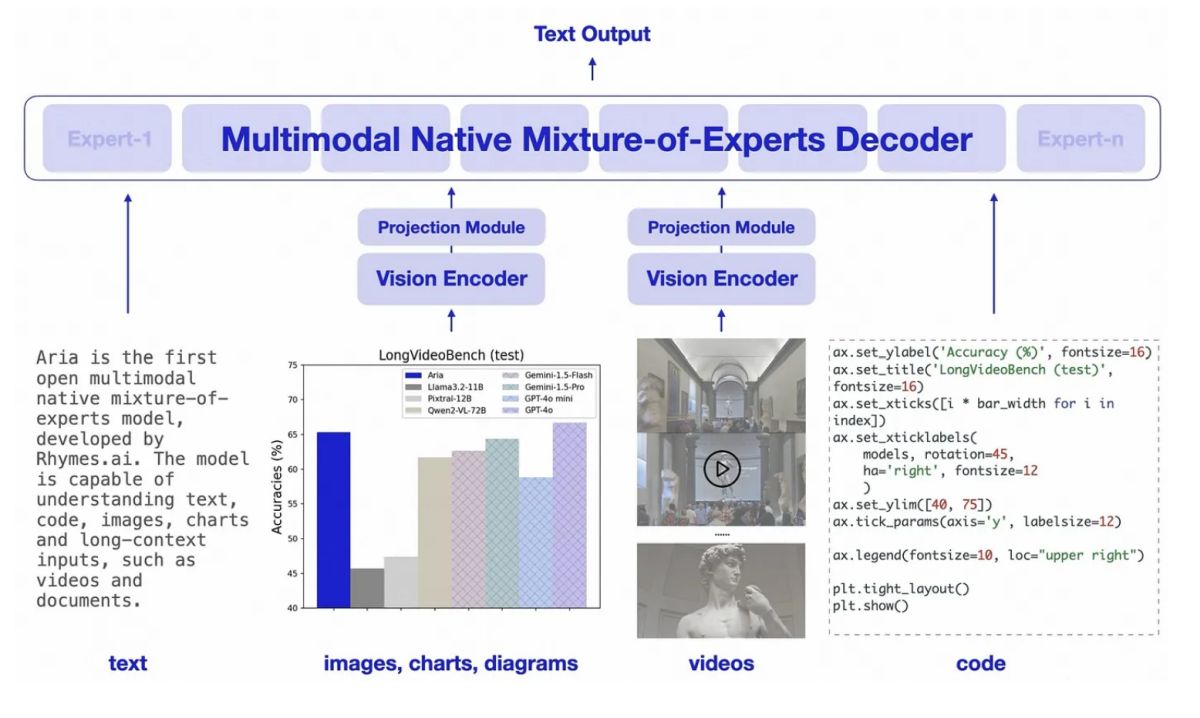

1. Aria

Недавно представленная ИИ-модель Aria от компании Rhymes AI заявлена как первая в мире мультимодальная Open Source-модель с архитектурой Mixture of Experts (MoE), которая может обрабатывать текст, код, изображения и видео — все в рамках одной архитектуры.

Эта универсальная модель относительно мощная по сравнению даже с более крупными моделями, но при этом более эффективная, поскольку в зависимости от задачи она избирательно использует множество подмоделей («мини-экспертов»), каждая из которых специализируется на разных аспектах входных данных или типов задач. Ее архитектура рассчитана на легкое масштабирование, поскольку для решения новых задач можно добавлять новых «экспертов», не перегружая систему. Aria отлично справляется с пониманием длинного мультимодального ввода, то есть быстро и точно разбирает длинные документы и видео.

2. Leopard

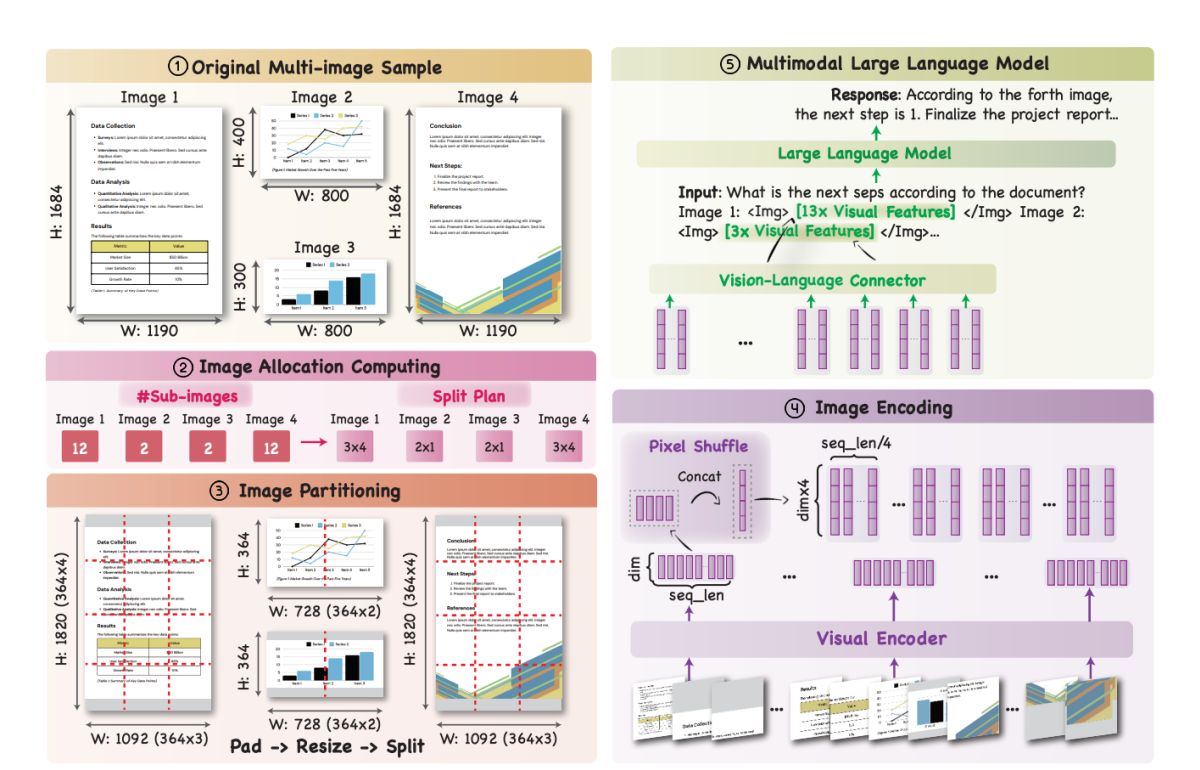

Leopard, разработанная междисциплинарной командой исследователей из Университета Нотр-Дам, Tencent AI Seattle Lab и Иллинойсского университета в Урбана-Шампейн (UIUC), представляет собой мультимодальную модель с открытым исходным кодом, специально предназначенную для задач, связанных с распознаванием изображений, содержащих текст.

Leopard призвана решить две самые большие проблемы в области мультимодального ИИ, а именно: нехватка высококачественных наборов данных с несколькими изображениями и баланс между разрешением изображения и длиной последовательности. Для достижения этой цели модель обучена с помощью набора данных, включающего более 1 млн. высококачественных, созданных человеком и синтетических данных, которые были собраны из реальных примеров. Она также находится в открытом доступе для использования в других моделях.

«Leopard отличается своим новым адаптивным модулем кодирования высокого разрешения, который динамически оптимизирует распределение длины визуальных последовательностей на основе исходных соотношений сторон и разрешений входных изображений, — отмечает Вэньхао Ю, старший научный сотрудник Tencent America и один из создателей Leopard. — Кроме того, она использует перестановку пикселов, чтобы без потерь сжимать длинные последовательности визуальных элементов в более короткие. Такая конструкция позволяет модели работать с множественными изображениями высокого разрешения без потери детализации и четкости».

Эти возможности делают Leopard отличным инструментом для понимания многостраничных документов (слайд-шоу, научные и финансовые отчеты), визуализации данных, понимания веб-страниц, а также для развертывания мультимодальных ИИ-агентов, способных решать задачи в визуально сложных средах.

3. CogVLM

Модель CogVLM, использующая методы глубокого объединения данных для достижения высокой производительности, расшифровывается как Cognitive Visual Language Model. Это современная Open Source-модель визуального языка, которая может быть использована для ответов на визуальные вопросы (VQA) и создания подписей к изображениям.

CogVLM использует механизм на основе внимания, который объединяет вложения текста и изображений и замораживает сетевые слои для поддержания высокой производительности. В ней также используется визуальный кодер EVA2-CLIP-E и адаптер многослойного перцептрона (MLP) для совместного отображения визуальных и текстовых признаков в одном и том же пространстве.

4. LLaVA

Large Language and Vision Assistant (LLaVA) — еще один современный вариант с открытым исходным кодом. Он использует Vicuna для декодирования языка и CLIP для тонкой настройки текстовых данных, следующих инструкциям. Модель была обучена с использованием текстовых данных, следующих инструкциям, сгенерированных ChatGPT и GPT-4. LLaVA использует обучаемую проекционную матрицу для отображения визуальных представлений в пространстве языковых вложений.

Как универсальный визуальный помощник, LLaVA может быть использована для создания более продвинутых чат-ботов, способных обрабатывать запросы, основанные на тексте и изображениях.

5. xGen-MM

Известный также как BLIP-3, этот современный набор мультимодальных моделей с открытым исходным кодом от Salesforce имеет ряд вариантов, включая базовую предварительно обученную модель, модель, настроенную на инструкции, и модель, настроенную на безопасность, которая предназначена для уменьшения вредных выводов.

Важным моментом является то, что эти системы были обучены на массивном открытом наборе данных на триллион токенов, состоящем из «чередующихся» изображений и текстовых данных, которые исследователи характеризуют как «наиболее естественную форму мультимодальных данных». Это означает, что модели умеют работать с текстом и множественными изображениями, что может быть полезно в самых разных сферах — например, в автономных транспортных средствах, при анализе изображений и диагностике заболеваний в здравоохранении, при создании интерактивных образовательных инструментов или рекламных маркетинговых материалов.

Заключение

Сейчас ведутся активные дебаты вокруг определения ИИ с открытым исходным кодом, сопровождаемые обвинениями в том, что крупные технологические компании выдают свои проприетарные модели ИИ за открытые («openwashing»), чтобы завоевать большие доверие и авторитет.

Независимо от того, как будут развиваться дебаты об ИИ с открытым исходным кодом, очевидно, что существует дальнейшая потребность в действительно открытых системах (и наборах данных), в которых особое внимание уделяется прозрачности, сотрудничеству и доступности и которые действительно соответствуют этике Open Source.