Сторонники закрытых базовых моделей искусственного интеллекта опасаются, что технология больших языковых моделей (LLM) с открытым исходным кодом может оказаться слишком опасной в чужих руках. Исполнительный директор Linux Foundation Джим Землин отверг это «смутное» представление на декабрьской конференции AI.dev в Калифорнии, сообщает портал The New Stack.

«Сегодня, к сожалению, мы начинаем наблюдать тенденцию отхода от открытости в генеративном ИИ и перехода к более закрытым моделям, доступным только через API, — сказал Землин. — Я нахожу эти аргументы довольно расплывчатыми и неубедительными».

Чем он это аргументирует? Во-первых, это новости из Европейского союза о первом в истории регулировании ИИ. В частности, LLM с открытым исходным кодом получили пропуск. Это радует, поскольку первоначальная версия этого закона жестко регулировала фундаментальные модели, включая Open Source-модели. Вняв возражениям, ЕС отказался от жестких ограничений и принял более мягкий подход.

Полный текст закона еще не опубликован. Другие регулирующие органы будут внимательно изучать документ в поисках рекомендаций, что дает некоторую надежду на то, что отдельные страны обратят внимание и поймут, почему LLM с открытым исходным кодом — это более безопасный подход, чем закрытие доступа к открытым инновациям.

Mistral услышала эту новость и начала действовать. Компания, состоящая из команды технологов OpenAI и Google, выпустила свою LLM с открытым исходным кодом вскоре после того, как появились новости из ЕС. В довершение всего она привлекла 415 млн. долл.

Сегодня большая часть технологий генеративного ИИ и LLM развивается на основе Open Source-технологий. ПО с открытым исходным кодом позволяет создавать базовые модели и модели машинного обучения. Технология LLM является результатом деятельности таких сообществ, как PyTorch, применения пакета Python, открытых наборов данных и академических исследований.

Землин считает, что большую опасность представляет закрытие открытых инноваций. Ограничения на открытость, как правило, приносят выгоду небольшому количеству действующих лиц.

А плохие игроки в любом случае будут игнорировать запреты. Open Source обеспечивает лучшую конфиденциальность и более безопасный мир. Как это связано с LLM? LLM категории Open Source, или модели с открытым исходным кодом прозрачны, поэтому люди могут находить уязвимости, проверять параметры и многое другое.

В проприетарных LLM такой прозрачности нет.

«Знаете, одна из вещей, которая немного странна в LLM, заключается в том, что мы не совсем знаем, как они работают, — говорит Землин. — А не зная, как они работают на самом деле, очень трудно получить второй атрибут — доверие, верно? Откуда нам знать, когда возникнут галлюцинации? Как мы узнаем, откуда поступают данные?»

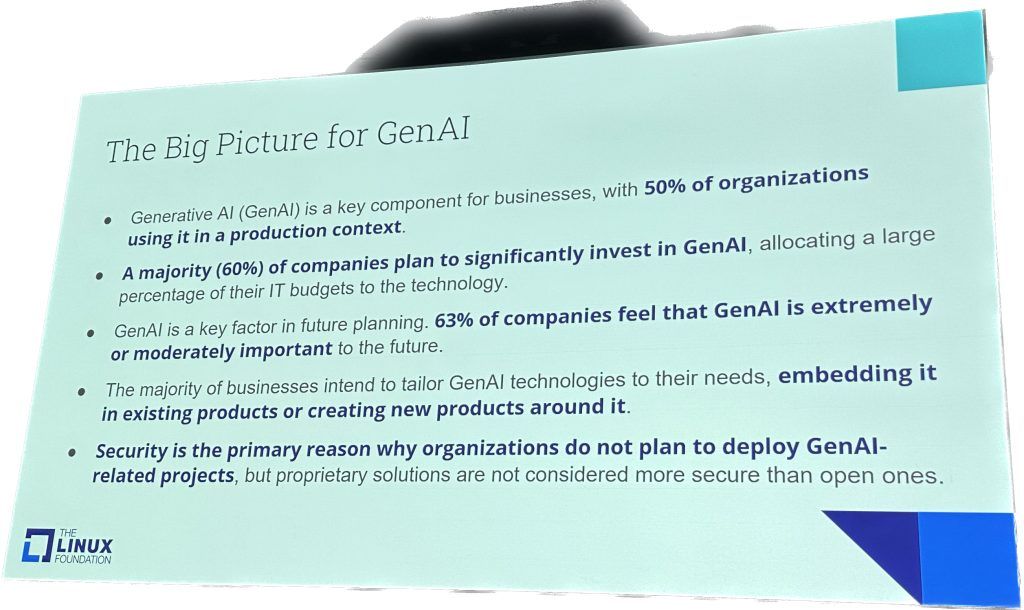

Предприятия беспокоятся о безопасности генеративного ИИ

Предприятия планируют инвестировать в генеративный ИИ. По словам Землина, их сдерживает безопасность. Он сослался на новое исследование Linux Foundation.

«Почти все люди, с которыми мы общались, сказали, что важно, чтобы технология, используемая для создания инструментов генеративного ИИ и базовых моделей, была открытой и размещалась в нейтральных организациях, на которые они могут рассчитывать в течение длительного периода времени в плане такой фундаментальной технологии, как эта, — сказал Землин. — Прозрачность дает людям на предприятиях уверенность, которая им необходима для принятия бизнес-решений и получения результатов».

Но так ли уж велика угроза от LLM с открытым исходным кодом? Для человечества — нет. Для технологических гигантов? Ну, это зависит от того, как вы определяете Open Source.