Существуют серьезные вопросы относительно конфиденциальности и безопасности данных при использовании приложений генеративного ИИ (GenAI), однако компании все равно спешат их внедрить. Таков вывод нового исследования Immuta «AI Security & Governance Report», в рамках которого было опрошено около 700 специалистов по данным. В отчете также говорится о некоторых преимуществах GenAI в плане инструментов обеспечения безопасности и конфиденциальности, сообщает портал Datanami.

Отчет рисует мрачную картину надвигающихся проблем с безопасностью и конфиденциальностью данных, поскольку компании спешат воспользоваться возможностями GenAI, предоставляемыми с помощью больших языковых моделей (LLM), таких как GPT-4, Llama 3 и др.

«В своем стремлении воспользоваться возможностями LLM и не отстать от быстрых темпов их внедрения, сотрудники всех уровней отправляют огромные объемы данных в неизвестные и непроверенные модели ИИ, — говорится в отчете. — Потенциально катастрофические затраты на обеспечение безопасности, связанные с этим, пока не ясны».

Половина специалистов по данным, опрошенных Immuta, говорят, что в их организациях установлено четыре или более систем или приложений ИИ. Однако внедрение GenAI сопряжено с серьезными проблемами конфиденциальности и безопасности.

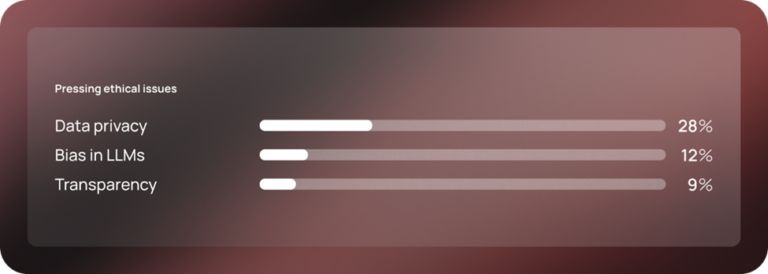

По данным Immuta, 55% опрошенных считают, что непреднамеренное раскрытие LLM конфиденциальной информации является одной из самых серьезных угроз. Чуть меньшее число (52%) опасаются, что их пользователи передадут конфиденциальные данные LLM через подсказки.

Что касается безопасности, то 52% опрошенных заявили, что их беспокоят враждебные атаки злоумышленников с использованием моделей ИИ. И чуть больше (57%) отметили, что за последний год они стали свидетелями «значительного увеличения числа атак с использованием ИИ».

В целом, согласно отчету Immuta, 80% опрошенных считают, что GenAI усложняет поддержание безопасности. Проблема усугубляется характером общедоступных LLM, таких как ChatGPT, которые используют введенную информацию в качестве исходного материала для последующих сессий обучения. Это создает «более высокий риск атак и других каскадных угроз безопасности», — отмечается в отчете.

«Эти модели очень дороги в обучении, обслуживании и проведении криминалистического анализа, поэтому они приносят много неопределенности, — говорит Джо Регенсбургер, вице-президент по исследованиям Immuta. — Мы не знаем, какого воздействия от них ожидать и в каких масштабах».

Несмотря на проблемы безопасности, связанные с GenAI, 85% специалистов по данным, опрошенных Immuta, полагают, что смогут решить любые проблемы, связанные с использованием этой технологии. Более того, две трети опрошенных уверены в своей способности сохранить конфиденциальность данных в эпоху ИИ.

«В эпоху облачных вычислений и ИИ проблемы безопасности данных и управления ими становятся все более сложными, — говорит Санджив Мохан, директора SanjMo. — Для управления безопасностью данных в сотнях информационных продуктов просто невозможно использовать устаревшие подходы».

Согласно опросу, хотя GenAI повышает риски, специалисты по данным обращаются к тому же GenAI за предоставлением новых инструментов и методов для автоматизации работы по обеспечению конфиденциальности и безопасности.

В частности, 13% опрошенных надеются, что ИИ поможет в выявлении фишинговых атак и обучении навыкам безопасности, 12% рассчитывают, что ИИ поможет в реагировании на инциденты, а 10% говорят, что он может помочь в моделировании угроз и создании «красной команды» для комплексной имитации реальных атак. Расширение и маскировка данных, аудит и отчетность, а также оптимизация совместной работы и операций центра управления безопасностью (SOC) также являются потенциальными областями применения ИИ.

«ИИ и машинное обучение способны автоматизировать процессы и быстро анализировать огромные массивы данных для улучшения обнаружения угроз, а также использовать передовые методы шифрования для защиты данных», — говорит Мэтт Диантонио, вице-президент по управлению продуктами Immuta.

По его словам, в конечном счете очевидно, что достижения в области ИИ меняют характер работы по обеспечению безопасности данных и конфиденциальности. Компании должны работать над тем, чтобы оставаться в курсе быстро меняющихся характера угроз и возможностей.

«По мере того, как организации совершенствуются в области ИИ, крайне важно снизить риски для данных, чтобы предотвратить непреднамеренное или злонамеренное использование конфиденциальных данных в моделях ИИ, — отмечает Диантонио. — Для этого крайне важно внедрить надежную стратегию безопасности и управления в отношении генерируемых ИИ потоков данных и выводов».