Когда я смотрю на усилия по созданию искусственного интеллекта, предпринимаемые такими компаниями, как Microsoft, то вижу, что основное внимание уделяется производительности, которая была главным преимуществом большинства технологических достижений на протяжении многих лет, пишет на портале Datanami Роб Эндерле, президент и главный аналитик Enderle Group.

Это связано с тем, что финансовую выгоду от производительности гораздо проще оценить в количественном выражении, чем любой другой показатель, включая качество. Такой акцент на производительности привел к отсутствию критического внимания к качеству и проблемам с качеством ИИ-платформ, о чем свидетельствует недавняя статья в WSJ о непосредственном сравнении пяти ИИ-инструментов — OpenAI ChatGPT, Microsoft Copilot, Google Gemini, Perplexity и Anthropic Claude, — в котором Copilot занял последнее место.

Это особенно проблематично для Copilot, поскольку он используется для кодирования. Ошибки в коде могут иметь серьезные последствия как для качества, так и для безопасности в будущем, поскольку эти проблемы вносятся с машинной скоростью, которая может превысить возможности их быстрого поиска или исправления.

Кроме того, ИИ ориентирован на то, чтобы пользователи делали то, что хотят, но все равно требует от них выполнения задач, например проверки и комментирования кода. Это развивает мем: «Я хочу, чтобы ИИ убирал мой дом и стирал белье, чтобы у меня было больше времени на то, что я люблю делать, например рисовать, писать и создавать музыку. Вместо этого создается ИИ, который рисует, пишет и создает музыку, оставляя меня заниматься тем, что я ненавижу».

На чем следует сосредоточить внимание ИИ

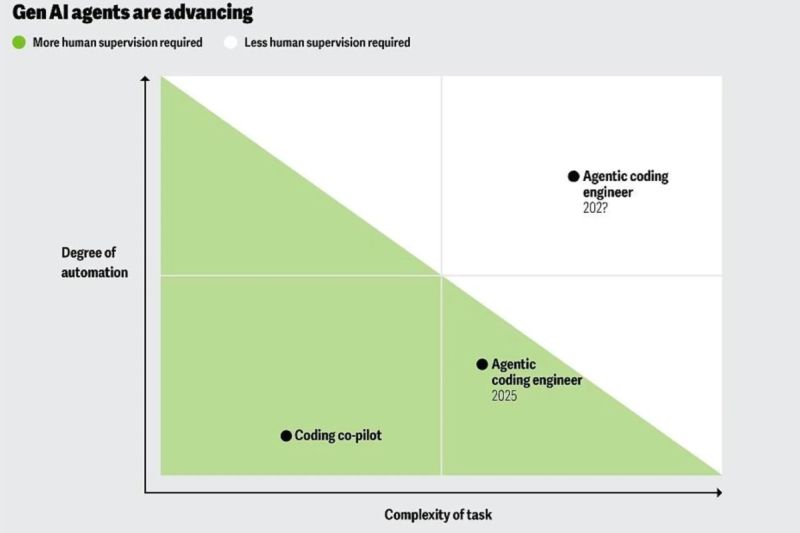

Несмотря на то что у нас есть дефицит рабочей силы, который необходимо решать (и для его решения создаются такие ИИ-предложения, как «инженер-программист искусственного интеллекта» Devin), и хотя производительность важна, производительность без фокусировки на лучшем направлении проблематична. Позвольте мне объяснить, что я имею в виду.

Когда я работал в IBM и переходил из отдела внутреннего аудита в отдел конкурентной разведки, я посетил занятие, которое запомнились мне на долгие годы. Преподаватель использовал диаграмму X/Y, чтобы подчеркнуть, что, когда дело доходит до реализации стратегии, большинство компаний почти сразу же сосредотачиваются на том, чтобы как можно быстрее достичь заявленной цели.

Он утверждал, что первым шагом должна быть не скорость. Первым шагом должна быть уверенность в том, что вы движетесь в правильном направлении. В противном случае вы будете двигаться все быстрее и быстрее в сторону от того места, куда должны двигаться, потому что сначала не утвердили цель.

На протяжении многих лет я видел, как это происходило в каждой компании, где я работал. По иронии судьбы, часто моя работа заключалась в том, чтобы обеспечить направление, но чаще всего решения принимались либо до того, как моя работа была представлена, либо тот, кто принимал решение, рассматривал меня и мою команду как угрозу. Если мы оказывались правы, а они — нет, это отражалось на репутации лица, принимающего решения. Изначально я думал, что это происходит из-за склонности к подтверждению своей точки зрения (сonfirmation bias), то есть нашей склонности принимать информацию, которая подтверждает нашу предыдущую позицию, и отвергать все, что ее не подтверждает. Позже я узнал о теории аргументации, которая утверждает, что еще со времен пещерных жителей в нас заложено стремление бороться за правоту несмотря на то, правы мы или нет, потому что те, кто считались правыми, получали лучших друзей и самые высокие посты в племени.

Я думаю, что отчасти причиной того, что мы не ориентируем ИИ на то, чтобы обеспечить принятие более правильных решений, является теория аргументации, которая заставляет руководителей думать, что если ИИ может принимать более правильные решения, то разве они не становятся лишними? Так зачем же так рисковать?

Но плохие решения, как я лично неоднократно убеждался, убивают компании. Сэм Альтман, укравший голос Скарлетт Йохансон, то, как OpenAI уволила Альтмана, и недостаточное внимание к качеству ИИ в пользу скорости — все это потенциально катастрофические решения, но OpenAI, похоже, не заинтересована в использовании ИИ для решения проблемы плохих решений (особенно стратегических), хотя мы и сами страдаем от них.

Подведение итогов

Мы почему-то не думаем об иерархии того, на чем в первую очередь нужно сосредоточить ИИ. Эта иерархия должна начинаться с поддержки принятия решений, переходить к повышению эффективности сотрудников, прежде чем заменить их предложениями, подобными Devin, и только потом переходить к скорости, чтобы избежать движения в неправильном направления на машинных скоростях.

На примере Tesla можно сказать, что концентрация на выводе «Автопилота» на рынок до того, как он сможет выполнять свою работу, привела к огромному количеству смертей, которых можно было бы избежать. Как в индивидуальном, так и в профессиональном плане мы страдаем от неправильных решений, которые стоят рабочих мест, снижают качество нашей жизни (глобальное потепление) и негативно влияют на качество наших отношений.

Наше недостаточное внимание или сопротивление ИИ, помогающему нам принимать более правильные решения, скорее всего, приведет к катастрофическим последствиям, которых в противном случае можно было бы избежать. Поэтому нам следует гораздо больше внимания уделять тому, чтобы не допускать подобных ошибок, а не потенциально ускорять их совершение, что, к сожалению, является тем путем, по которому мы идем.