Исследователи из Массачусетского технологического института (MIT) создали репозиторий рисков ИИ для консолидации известных данных. Один из их выводов? Дезинформация — это наименее изученная ИИ-угроза, сообщает портал ZDNet.

К настоящему времени риски ИИ в различных областях применения хорошо документированы, но информацию о них при принятии нормативных, политических или бизнес-решений трудно получить в одном месте. Стремясь исправить эту ситуацию Лаборатория компьютерных наук и искусственного интеллекта MIT (CSAIL) запустила репозиторий рисков ИИ — базу данных, содержащую более 700 задокументированных рисков ИИ. Как сообщает CSAIL, эта база данных является первой в своем роде и будет постоянно обновляться, чтобы ее можно было использовать в качестве активного ресурса. Проект был вызван опасениями, что глобальное внедрение ИИ опережает понимание людьми и организациями рисков его внедрения.

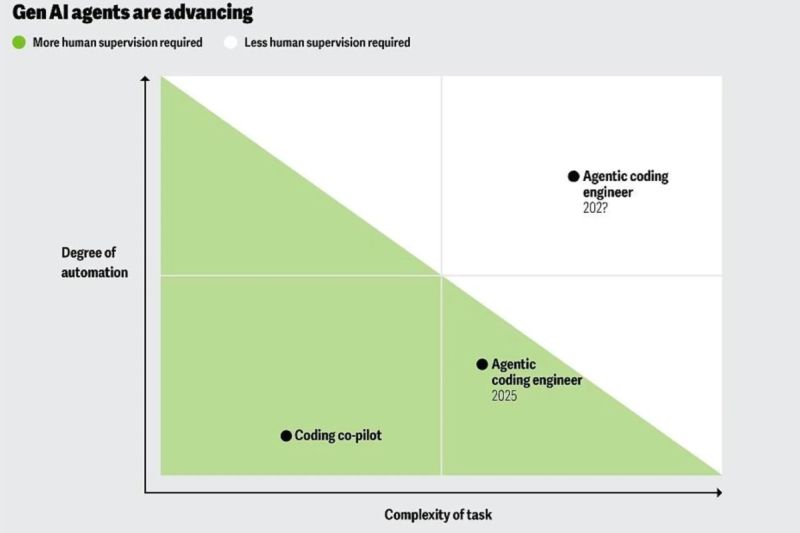

Согласно CES «Tracking Firm Use of AI in Real Time: A Snapshot from the Business Trends and Outlook Survey», в период с сентября 2023 г. по февраль 2024 г. использование ИИ в отраслях экономики США выросло с 3,7 до 5,45%, то есть на 47%. В то же время исследователи из CSAIL и MIT FutureTech Lab обнаружили, что «даже самая тщательная индивидуальная система не учитывает примерно 30% рисков, выявленных во всех рассмотренных системах».

Фрагментарность публикаций по рискам, связанным с ИИ, может затруднить для политиков, специалистов по оценке рисков и других заинтересованных сторон получение полного представления о стоящих перед ними проблемах. «Трудно найти конкретные исследования рисков в некоторых нишевых областях, где используется ИИ, например, в области вооружений и в системах поддержки принятия решений в армии, — говорит Таниэль Юсеф, сотрудник Кембриджского исследовательского института, не связанный с проектом. — Без ссылок на эти исследования может быть трудно обсуждать технические аспекты ИИ-риска с нетехническими экспертами. Этот репозиторий поможет нам в этом».

Без базы данных некоторые риски могут остаться незамеченными и не быть рассмотренными должным образом, объясняет команда проекта.

«Поскольку публикации по рискам ИИ разбросаны по рецензируемым журналам, препринтам и отраслевым отчетам и весьма разнообразны, я беспокоюсь, что лица, принимающие решения, могут невольно обращаться к неполным обзорам, упускать важные проблемы и развивать коллективные „слепые пятна“», — говорит руководитель проекта доктор Питер Слэттери.

Чтобы решить эту проблему, исследователи из MIT совместно с коллегами из других институтов, включая Университет Квинсленда, Future of Life Institute, KU Leuven и Harmony Intelligence, создали базу данных. Репозиторий призван обеспечить «доступный обзор ландшафта рисков ИИ» и выступить в качестве универсального справочника, которым смогут пользоваться все — от исследователей и разработчиков до представителей бизнеса и политиков.

Для его создания исследователи разработали 43 фреймворка классификации рисков, изучив академические документы и базы данных и побеседовав с несколькими экспертами. Отобрав более 700 рисков из этих 43 фреймворков, исследователи классифицировали каждый из них по причинам (когда или почему он возникает), доменам и поддоменам (например, «Дезинформация» и «Ложная или вводящая в заблуждение информация», соответственно).

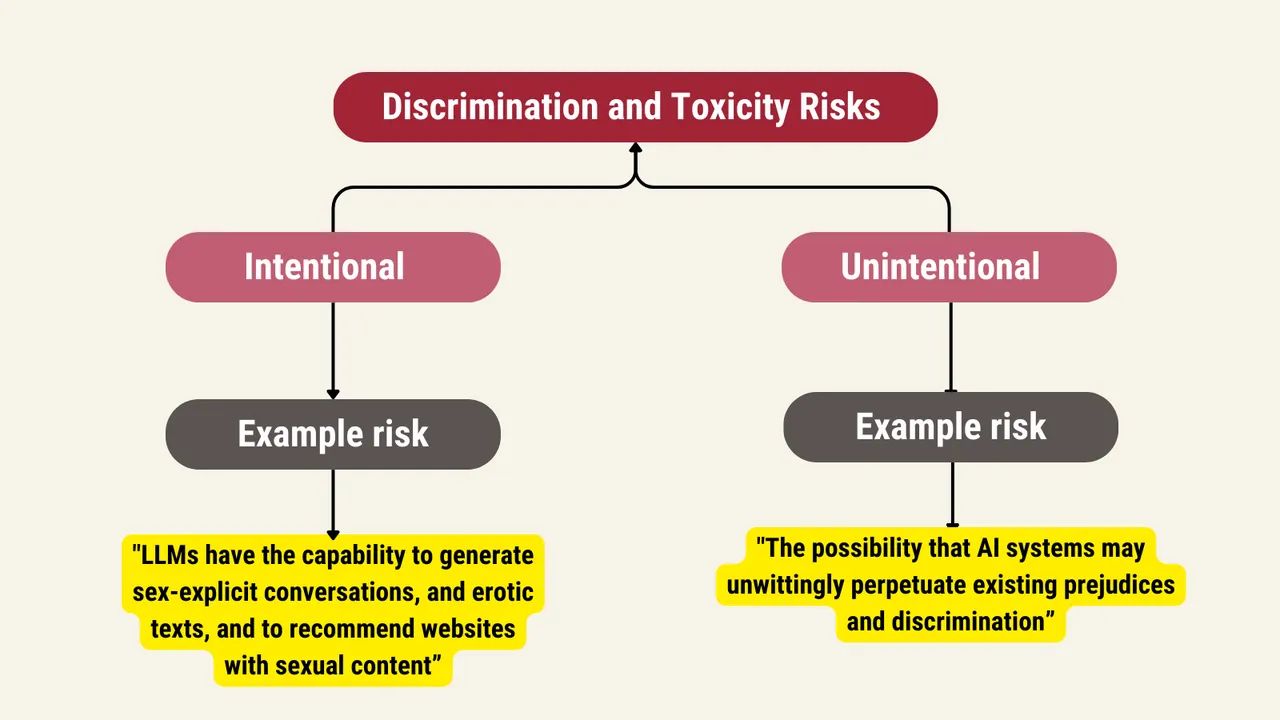

Риски варьируются от дискриминации и искажения информации до мошенничества, целенаправленных манипуляций и небезопасного использования. «Наиболее часто рассматриваемые области рисков, — отмечают авторы проекта, — включают „Безопасность, сбои и ограничения систем ИИ“ (76% документов), „Социально-экономический и экологический ущерб“ (73%), „Дискриминация и токсичность“ (71%), „Конфиденциальность и безопасность“ (68%) и „Вредоносные субъекты и неправомерное использование“ (68%)».

Исследователи обнаружили, что человеко-машинное взаимодействие и дезинформация являются наименее освещенными проблемами во всех фреймворках рисков. 51% анализируемых рисков связан с системами ИИ, а не с людьми, которые отвечают за 34% рисков, и 65% рисков возникли после внедрения ИИ, а не во время разработки.

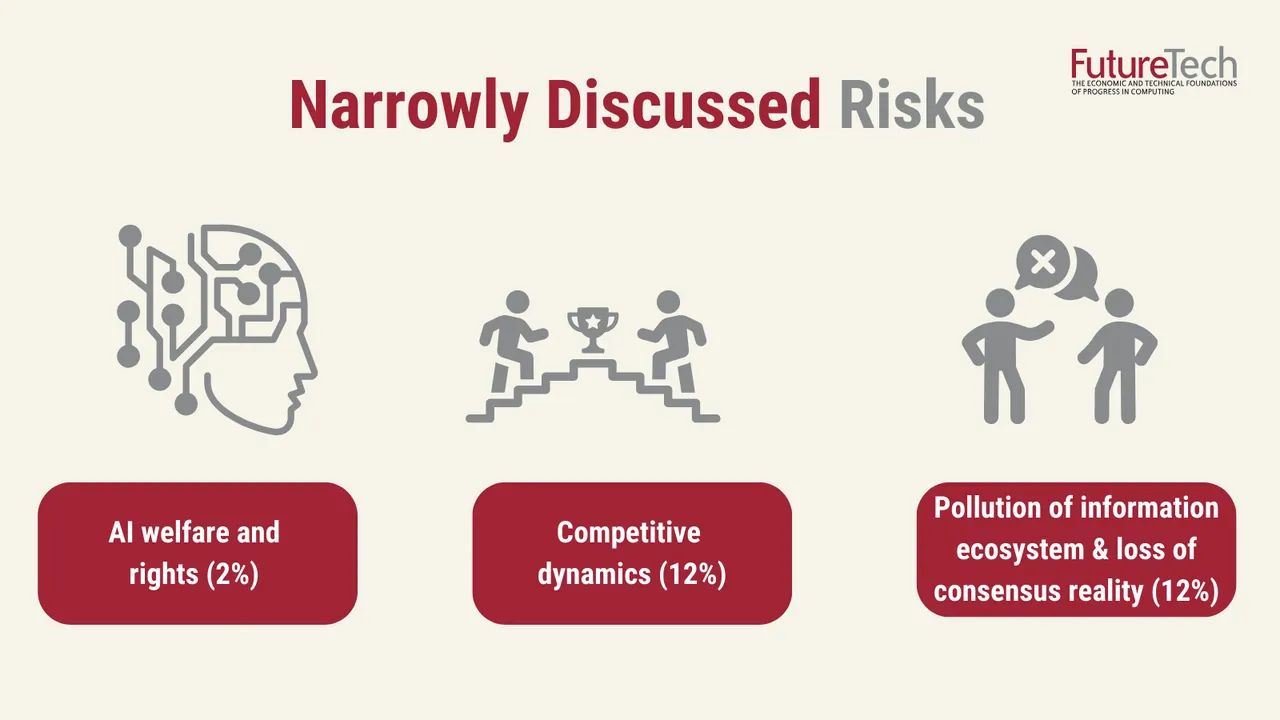

Такие темы, как дискриминация, нарушение конфиденциальности и отсутствие возможностей, оказались самыми обсуждаемыми, они фигурируют более чем в 50% документов, изученных исследователями. Обеспокоенность тем, что ИИ наносит ущерб информационным экосистемам, упоминается гораздо реже — всего в 12% документов.

В MIT надеются, что репозиторий поможет лицам, принимающим решения, лучше ориентироваться в рисках, связанных с ИИ, особенно в условиях быстрого появления большого количества инициатив по управлению ИИ во всем мире.

Репозиторий «является частью более масштабных усилий, направленных на то, чтобы понять, как мы реагируем на риски, связанные с ИИ, и определить, есть ли пробелы в наших текущих подходах, — говорит доктор Нил Томпсон, исследователь и руководитель FutureTech Lab. — Мы начинаем с составления всеобъемлющего контрольного списка, который поможет нам понять широту потенциальных рисков. Мы планируем использовать его для выявления недостатков в организационных мерах реагирования. Например, если все сосредоточены на одном типе риска и не обращают внимания на другие, схожие по важности, мы должны это заметить и устранить».

Далее исследователи планируют использовать репозиторий для анализа публичных документов компаний и разработчиков ИИ, чтобы определить и сравнить подходы к рискам по секторам.