Недавнее исследование показало, что стратегии, которые используют большие языковые модели (LLM) для обработки человеческих разговоров, поразительно похожи на те, что использует человеческий мозг, сообщает портал eWeek.

Научная работа, опубликованная в корпоративном блоге Google Research группами исследователей Google AI, Принстонского университета, Нью-Йоркского университета и Еврейского университета в Иерусалиме, включает в себя результаты пяти лет индивидуальных исследований, направленных на изучение различий и сходств между современным поколением LLM и человеческим мозгом.

LLM помогают системам искусственного интеллекта понимать, обрабатывать и генерировать человеческий язык, анализируя большие массивы текстовых данных и применяя такие стратегии, как обучение с подкреплением и предсказание следующего слова, для генерации шаблонов естественной речи.

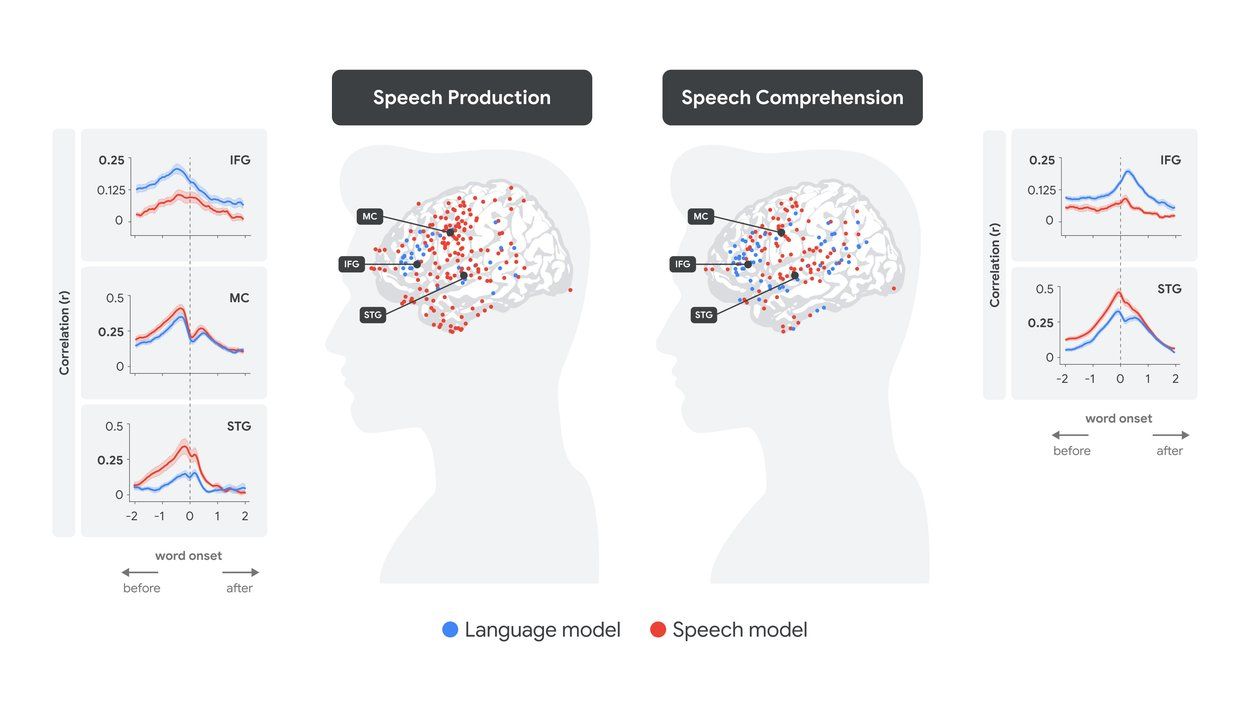

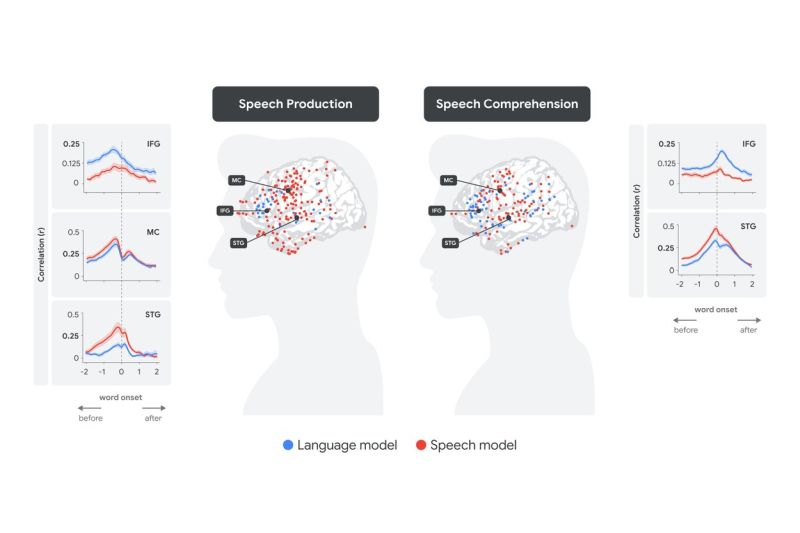

Исследователи использовали текст, сгенерированный преобразователем речи в текст Whisper, для части исследования, связанной с ИИ. Сравнив результаты с данными с внутричерепных электродов, использовавшихся для записи 100 часов реальных разговоров, они обнаружили «удивительное соответствие» между человеческим мозгом и внутренними представлениями ИИ — так называемыми вложениями.

Whisper извлекает из каждого слова два вложения: речевое и языковое. Исследование показало, что вложения Whisper очень похожи на нейронную активность, наблюдаемую в речевой и языковой областях человеческого мозга.

Различия и сходства

Предыдущие исследования показали, что языковые области человеческого мозга активно пытаются предсказать следующее слово в предложении еще до того, как оно будет произнесено вслух. Лучшие LLM используют несколько различных стратегий, включая предсказание следующего слова, чтобы лучше понимать естественный язык. Но есть и заметные различия между LLM и человеческим мозгом. В то время как современные инструменты генеративного ИИ и LLM достаточно мощны, чтобы обрабатывать сотни тысяч слов одновременно, языковые области человеческого мозга обрабатывают слова последовательно, или по одному за раз.

Что это значит для будущего LLM?

По словам авторов работы, их недавнее исследование поможет нам глубже понять нейронную активность в человеческом мозге, особенно в областях речи и языка. Исследование также научит разработчиков ИИ, как эффективнее обучать модели ИИ — и делать их более похожими на человеческий мозг.

«Наша цель — создать инновационные, биологически вдохновленные искусственные нейронные сети, которые будут обладать улучшенными возможностями для обработки информации и функционирования в реальном мире, — пишут исследователи. — Мы планируем добиться этого, адаптируя архитектуру нейросети, протоколы обучения и данные для тренировок, которые лучше соответствуют человеческому опыту».