Поисковые системы прошли путь от простого сопоставления ключевых слов к многоуровневым архитектурам, способным анализировать контекст, поведение, историю взаимодействий и мультимодальные данные. Сегодня задача поиска — не только в том, чтобы «выдать ссылки», а в том, чтобы интерпретировать цель пользователя и помочь ему выполнить действие.

Обладая большим опытом работы с высоконагруженными системами поиска, в этой колонке я рассказываю, как меняется архитектура поиска под воздействием AI, какие инфраструктурные вызовы возникают и какие инженерные подходы позволяют масштабировать такие решения.

Эволюция цели поиска

Цель традиционных поисковых систем — дать пользователю наиболее релевантные результаты по заданному запросу. Раньше системы опирались на индекс цитирования сайта и статическое ранжирование. Такой подход предполагал, что чем авторитетнее источник, тем скорее пользователь найдет ответ на свой запрос. Но уже 10 лет назад можно было закупить ссылочную массу и вывести даже некачественный ресурс в топ по определенным запросам.

Статическое ранжирование тоже потеряло актуальность — информационный поток обновляется так быстро, что поисковые роботы не успевают его отследить. Кроме того, инфоповоды появляются не только на сайтах, но и в соцсетях, видео, подкастах — а традиционные системы учитывают их хуже.

Современные системы стремятся минимизировать действия пользователя — чтобы не просто показать релевантные результаты, а понять и интерпретировать намерение, сориентироваться с помощью контекста и предложить конкретные действия.

Сегодня поисковая система должна учитывать:

- намерение запроса;

- контекст;

- персональные сигналы;

- свежесть данных;

- мультимодальные источники.

Поиск становится диалогом: пользователю больше не нужно формулировать «идеальный» запрос — система сама адаптируется к цели.

Как AI меняет архитектуру поиска

Для современных задач поиска требуется применение AI, который будет понимать контекст, тональность и цель запроса, учитывать предыдущие действия и интересы пользователя, а также комбинировать данные из разных источников, включая видео и соцсети. На смену статическому ранжированию приходит динамическое, которое использует ranking-модели, обученные на поведенческих данных, и быструю аналитику real-time информации.

Таким образом, ранжирование превращается в мини-пайплайн, учитывающий намерение. А поисковая архитектура включает несколько независимых слоев, каждый из которых решает отдельную задачу:

- Retrieval Layer — «базовый» слой, который находит все потенциально релевантные результаты. Иными словами, на этом этапе происходит извлечение кандидатов из индекса — для этого используются векторные представления, hybrid retrieval и быстрые ANN-индексы.

- Ranking / Re-ranking Layer — интеллектуальная сортировка кандидатов с учетом поведения, качества источника, времени появления и семантической близости с помощью

ML-моделей. - Reasoning / Interpretation Layer (LLM / Understanding) — интерпретация смысла с помощью LLM. Модели разбирают сложные запросы и уточняют намерение, понимают мультимодальные элементы, объединяют результаты из нескольких типов контента.

- Generation / Agent Layer — формирование ответа или выполнение действия. Современные поисковые системы не просто выдают результат, а генерируют ответ на естественном языке и предлагают пользователю сразу совершить действие — например, купить товар или забронировать отель.

Такая архитектура делает поиск модульным: отдельные компоненты можно масштабировать, обновлять и тестировать независимо друг от друга.

Для улучшения поиска система учитывает каждое взаимодействие пользователя: клики, просмотры, время, проведенное на сайтах, и т.д. Благодаря этому пользователь получает персонализированные результаты с учетом поведения и контекста.

А для поиска среди любого типа контента используются мультимодальные модели (VLM), которые обучены понимать и связывать между собой визуальные и языковые данные. Например, они могут найти товар по фото, проанализировать график, распознать навигацию по карте или понять, что происходит на видео.

Сейчас в индустрии наблюдается увеличение числа стартапов по разработке «умных» поисковых систем — например, известный многим пользователям Perplexity, а также Exa AI, Keenable и другие. Крупные корпорации — такие как Google и Bing — тоже внедряют AI в свои поисковые движки.

Real-time data как ключевой фактор релевантности

Релевантность теперь определяется не только качеством источника. Важна способность быстро реагировать на изменения, события и тренды. В эпоху real-time контента данные меняются каждый день, и статья полугодовой давности уже может быть неактуальной. Поэтому необходимо применять особые инструменты и механики, которые позволят ориентироваться на real-time data:

- Потоковая обработка данных (Kafka, Kinesis, Flink) — обеспечивает доставку данных и пользовательских сигналов прямо в

ML-модели. - Обновление feature store в реальном времени —- модели получают свежие признаки в потоковом режиме.

- Online learning/delayed feedback loops —

ML-модели частично дообучаются на свежих событиях, не дожидаясь полного пересчета.

На первый план выходят такие метрики, как latency и feature freshness. Latency измеряет скорость реакции в миллисекундах — это напрямую влияет на пользовательский опыт и, соответственно, бизнес-результаты. Оптимальный показатель здесь —

Feature freshness — это время от появления данных до их применения в модели. От этой метрики зависит релевантность выдачи, точность персонализации и доверие пользователей. Свежесть признаков напрямую влияет на персонализацию и доверие пользователя.

Значимость real-time data показывает и изменение паттернов потребления информации. Если старшее поколение чаще следит за новостями по телевизору, то более молодая аудитория отдает предпочтение соцсетям (VK, TikTok) и сообществам (например, в Telegram), где информация появляется практически в реальном времени.

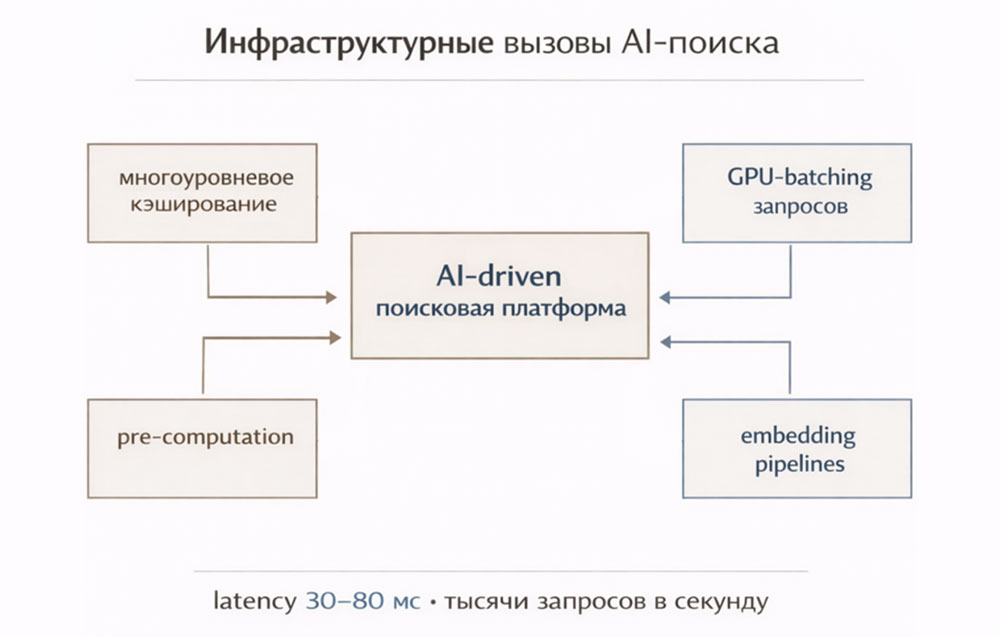

Инфраструктурные вызовы при разработке AI-driven поисковых систем

В крупной поисковой платформе критические важными становятся показатели скорости отклика (latency) и способности обрабатывать запросы при высоких нагрузках (throughput). Например, современные поисковые стеки работают с задержками

Для гибкости и легкого масштабирования я рекомендую использовать микросервисную сегментацию — выделив тяжелые компоненты (например,

Также этот подход обеспечивает отказоустойчивость — например, если сервис рекомендаций на данный момент недоступен, система может вернуться к базовому

AI-агенты и поиск будущего

Классические поисковые системы умеют быстро находить информацию за счет поиска по индексам и использования retrieval-механизма, но не понимают, зачем она нужна пользователю.

Задача будущего — объединить классический поиск (скорость, масштаб, полнота) и агентность (понимание задачи и выполнение действий). Поисковая система сможет не только предлагать наиболее релевантные, в зависимости от контекста и пользовательского поведения, варианты — но и выполнять определенные действия, подключаясь по API к соответствующим сервисам.

Например: пользователь спрашивает о турах в Италию — система подберет варианты, проверит цены, предложит звонок с турагентом и оформит бронь.

Поиск будущего станет инициативным. Он сможет не просто выдавать результат, а понимать и предлагать следующий шаг, исходя из контекста — например, посмотреть подходящие экскурсии после бронирования тура. Таким образом, поиск станет диалогом, где агент будет выполнять роль ассистента, добиваясь полноценного удовлетворения пользовательского запроса. А качество поиска в будущем будет измеряться не только по релевантности (NDCG, CTR), но и по успешности выполнения цели пользователя.

К традиционным метрикам добавятся бизнес-ориентированные показатели:

- Goal Completion Rate — процент пользователей, успешно достигших цели;

- Action Success Rate — процент завершенных действий из общего числа попыток;

- Conversion to next step — число конверсий в следующий шаг.

Таким образом, поиск переходит от статического ранжирования к динамической AI-архитектуре, основанной на намерениях. Будущее поиска — это системы, которые понимают контекст, интерпретируют цель, действуют от имени пользователя.

Поисковая строка перестает быть интерфейсом «вопрос—ответ» и превращается в точку входа к интеллектуальному агенту, который помогает довести задачу до результата.