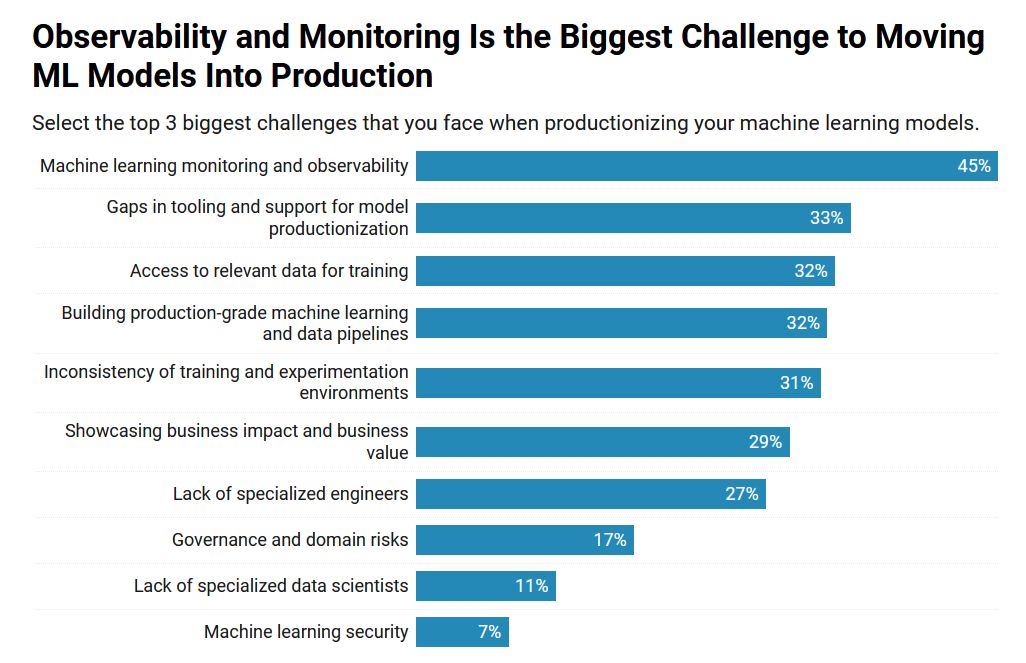

Согласно новому исследованию The Institute for Ethical AI & Machine Learning «The State of MLOps Survey», проведенному в IV квартале 2024 г., наблюдаемость и мониторинг — а не безопасность — являются наиболее часто упоминаемыми проблемами при внедрении моделей машинного обучения в производство, сообщает портал The New Stack.

Другой ключевой вывод: в дорожных картах пользователей преобладают инструменты, созданные на заказ, поскольку лишь немногие инструменты поставщиков получили значительное распространение.

В целом 44% из 170 опрошенных практиков являются инженерами МО, и примерно столько же идентифицируют себя как специалисты в области науки о данных или MLOps-инженеры.

Только 7% респондентов заявили, что безопасность MО входит в тройку их главных проблем, и только 17% сказали то же самое о рисках управления и доменных рисках. Этот вывод значительно отличается от результатов других исследований, в которых безопасность и управление ИИ назывались в числе самых серьезных препятствий для более широкого внедрения. Вероятно, специалисты-практики считают, что безопасность ИИ связана только с возможностью взлома модели, в то время как другие лица, принимающие решения в сфере ИТ, больше беспокоятся об общем доступе к корпоративным и личным данным.

Похоже, что каждое предприятие, как минимум, экспериментирует с генеративным ИИ и агентами ИИ, которые опираются на большие языковые модели (LLM). В то же время продолжает расти применение предиктивной аналитики и компьютерного зрения. В условиях расширения масштабов использования этих приложений разработчикам требуются инженеры по данным, SRE и другие специалисты для решения задач первого и второго дня. В ответ на этот вызов MLOps превращается в реально применяемую дисциплину, за которой следуют LLMOps и GenAIOps.

Независимо от используемой терминологии, наблюдаемость и мониторинг LLM — это то, на что необходимо обратить внимание.

Заказные инструменты в сравнении с инструментами поставщиков

В ходе опроса были заданы вопросы о девяти различных составляющих технологического стека, необходимых для использования ИИ и МО. Вот некоторые примечательные выводы:

- 65% участников опроса используют управляемую модель или API-сервис LLM. Среди тех, кто применяет этот тип сервиса, чаще всего встречаются OpenAI (38%), AzureAI (20%) и Amazon Bedrock (12%).

- MLflow является лидером по использованию реестра моделей и/или отслеживанию экспериментов. Среди тех, кто применяет эти инструменты, 48% чаще всего используют MLflow. Следующими по частоте использования в этой категории стали инструменты, созданные на заказ (16%), и Weights & Biases (12%).

- Среди пользователей ETL/оркестраторов рабочих процессов 40% чаще всего используется Airflow. Следующими по частоте использования в этой категории стали инструменты, созданные на заказ (17%) и Argo Workflows (11%).

- Среди пользователей сервисов моделей реального времени 46% чаще всего используют FastAPI/Flask Wrapper. Чаще всего этот инструмент применяют специалисты по исследованию данных (70%). Следующими по частоте использования в этой категории стали инструменты, созданные на заказ (16%), и AWS SageMaker (12%).